Con el uso de la inteligencia artificial de NVIDIA, Dell Technologies, Inspur, Microsoft Azure y Supermicro establecido récords para entrenar modelos de inteligencia artificial rápidamente en los últimos puntos de referencia de MLPerf publicados hoy

¿Quién acaba de establecer nuevos récords de velocidad para entrenar modelos de IA rápidamente? Dell Technologies, Inspur, Supermicro y, en su debut en los puntos de referencia de MLPerf, Azure, todos con la IA de NVIDIA.

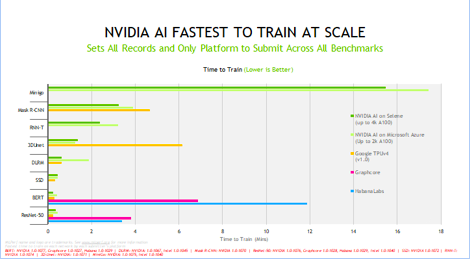

La plataforma estableció récords a lo largo de las ocho cargas de trabajo populares en los resultados de capacitación 1.1 de MLPerf anunciados hoy.

Las GPU NVIDIA A100 Tensor Core ofrecieron el mejor rendimiento normalizado por chip. Escalaron con la red NVIDIA InfiniBand y la batería de software para ofrecer el tiempo más rápido para entrenar en Selene, la supercomputadora de IA interna basada en la NVIDIA DGX SuperPOD modular.

Un Cloud Navega Hacia la Cima Cuando se trata de entrenar modelos de IA, la instancia NDm A100 v4 de Azure es la más rápida del planeta, según los últimos resultados. Ejecutó todas las pruebas en la última ronda y escaló hasta 2,048 GPUs A100.

Azure mostró no solo un gran rendimiento, sino también un gran rendimiento que está disponible para que cualquiera lo pueda alquilar y usar hoy en seis regiones de los EE. UU.

El entrenamiento de IA es un gran trabajo que requiere mucho esfuerzo. Y se desea que los usuarios entrenen modelos a una velocidad récord con el servicio o sistema de su elección.

Es por eso que se habilita NVIDIA AI con productos para servicios en el cloud, servicios de coubicación, corporaciones y también centros de computación científica.

Los creadores de servidores muestran sus fortalezas Entre los OEMs, Inspur estableció la mayor cantidad de récords en rendimiento de un solo nodo con sus sistemas de GPUs de ocho vías NF5688M6 y el NF5488A5 refrigerado por líquido. Dell y Supermicro establecieron récords en sistemas de GPU A100 de cuatro vías.

Un total de 10 socios de NVIDIA presentaron resultados en la ronda, ocho OEMs y dos proveedores de servicios en el cloud. Constituyeron más del 90 por ciento de todas las presentaciones.

Esta es la quinta y más sólida demostración hasta la fecha del ecosistema de NVIDIA en las pruebas de entrenamiento de MLPerf.

Sus socios hacen este trabajo porque saben que MLPerf es el único punto de referencia estándar de la industria y revisado por pares para el entrenamiento y la inferencia de IA. Es una herramienta valiosa para los clientes que evalúan plataformas y proveedores de IA.

Servidores certificados por velocidad Baidu, PaddlePaddle, Dell Technologies, Fujitsu, GIGABYTE, Hewlett Packard Enterprise, Inspur, Lenovo y Supermicro presentaron resultados en data centers locales, ejecutando trabajos en uno o varios nodos.

Casi todos los socios OEMs de NVIDIA realizaron pruebas en Sistemas Certificados por NVIDIA, servidores que se validan para clientes empresariales que desean computación acelerada.

La variedad de presentaciones muestra la amplitud y madurez de una plataforma NVIDIA que brinda soluciones óptimas para empresas que trabajan a cualquier escala.

Ambas cosas: rápido y flexible NVIDIA AI fue la única plataforma que los participantes utilizaron para realizar presentaciones en todos los puntos de referencia y casos de uso, lo que demuestra su versatilidad y alto rendimiento. Los sistemas que son rápidos y flexibles proporcionan la productividad que los clientes necesitan para acelerar su trabajo.

Los puntos de referencia de capacitación cubren ocho de las cargas de trabajo y escenarios de IA más populares de la actualidad: visión por computadora, procesamiento del lenguaje natural, sistemas de recomendación, aprendizaje por refuerzo y más.

Las pruebas de MLPerf son transparentes y objetivas, por lo que los usuarios pueden confiar en los resultados para tomar decisiones de compra informadas. El grupo de evaluación comparativa de la industria, formado en mayo de 2018, está respaldado por docenas de líderes de la industria, incluidos Alibaba, Arm, Google, Intel y NVIDIA.

Aceleraciones 20 Veces Mayores en tres años Mirando hacia atrás, los números muestran ganancias de rendimiento en las GPUs A100 de más de 5 veces sólo los últimos 18 meses. Eso es gracias a las continuas innovaciones en software, la mayor parte del trabajo de NVIDIA en estos días.

El rendimiento de NVIDIA ha aumentado más de 20 veces desde que se estrenaron las pruebas MLPerf hace tres años. Esa aceleración masiva es el resultado de los avances que hacen en su oferta de batería completa de GPUs, redes, sistemas y software.

Software en constante mejora Los últimos avances provienen de múltiples mejoras de software.

Por ejemplo, utilizando una nueva clase de operaciones de copia de memoria, logran operaciones 2.5 veces más rápidas en el punto de referencia 3D-UNet para imágenes médicas.

Gracias a las formas en que puede ajustar las GPUs para el procesamiento en paralelo, logran un aumento del 10 por ciento en la prueba Mask R-CNN para la detección de objetos y un aumento del 27 por ciento para los sistemas de recomendación. Simplemente superpusieron operaciones independientes, una técnica que es especialmente poderosa para trabajos que se ejecutan en muchas GPUs.

Amplían el uso de gráficos CUDA para minimizar la comunicación con la CPU del host. Eso trajo una ganancia de rendimiento del 6 por ciento en el punto de referencia ResNet-50 para la clasificación de imágenes.

Implementan dos nuevas técnicas en NCCL, una biblioteca que optimiza las comunicaciones entre las GPUs. Eso aceleró los resultados hasta en un 5 por ciento en modelos de lenguaje grandes como BERT.

Aprovechar el arduo trabajo Todo el software que usan está disponible en el repositorio MLPerf, por lo que todos pueden obtener resultados de clase mundial. Incorporan continuamente estas optimizaciones en contenedores disponibles en NGC, el centro de software para aplicaciones de GPU.

Es parte de una plataforma de batería completa, probada en los últimos puntos de referencia de la industria y disponible a través de una variedad de socios para abordar trabajos reales de IA hoy.

“Con los resultados positivos y sobresalientes que tuvo NVIDIA en estas pruebas de MLPerf para el entrenamiento de Modelos de Inteligencia Artificial, reafirman su compromiso con los clientes en América Latina, para emprender con ellos proyectos ambiciosos de IA” dijo Marcio Gomes de Aguiar, Director Regional para América Latina de NVIDIA Enterprise.